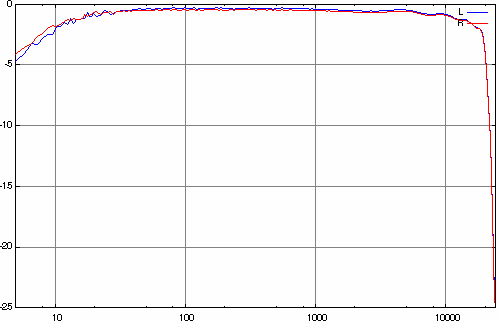

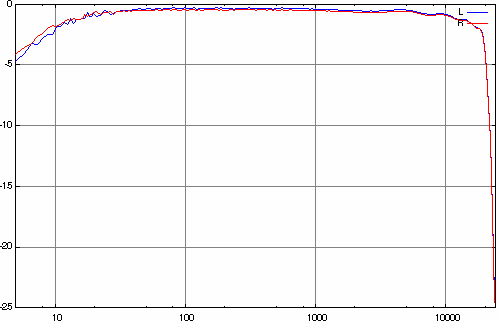

Loopback Frequenzgang einer Terratec XLerate (Aureal Vortex Chip) bei 48 kHz, gemessen mit rosa Rauschen. Die Karte verwendet im Übrigen "nur" zweifach Oversampling.

© 2005 Marcel Müller

Abstract:

Das Thema Soundkarten ist aus Qualitätsgesichtspunkten so alt wie leidig.

Ständig neue Modelle in der Konsumentenklasse unterbieten sich gegenseitig

in ihren inneren Werten. In diesem Artikel sind häufig anzutreffende

Probleme beschrieben, und wie man sie diagnostizieren und gegebenenfalls

umgehen kann. Insbesondere möchte ich dabei herausstellen, dass die

technischen Parameter dieser Klasse (44 bzw. 48kHz, 16Bit, Stereo), sofern

sie sauber umgesetzt sind, durchaus hinreichend für audiophile und auch

messtechnische Zwecke sind.

Der Artikel konzentriert sich auf die analogen Ein- und Ausgänge sowie die

Erfordernisse für den ordnungsgemäßen Betrieb derselben. Treiber-Querelen

und im Besonderen betriebssystemspezifische Fragen werden ebenso wenig

behandelt, wie MIDI- oder SP-DIF-Fragen.

Nachdem meine erste Soundkarte wohl ein Glücksgriff war (Sound Blaster 16 ASP = CT1740) und mir lange Jahre gute Dienste erwiesen hat, musste ich danach schnell feststellen, dass das in der Konsumentenklasse die absolute Ausnahme ist. Ab diesem Zeitpunkt habe ich mich systematisch mit dem Thema auseinandergesetzt. Meine Erfahrungen habe ich hier zusammengefasst.

| Parameter | Aufnahme | Wiedergabe | Kritikalität | Bemerkung |

|---|---|---|---|---|

| Frequenzgang, Phasengang | X | X | mittel | Lästig, aber im allgemeinen kompensierbar. |

| Aliasing (Spiegelfrequenzen) | X | - | mittel | Dagegen kann man mit vertretbarem Aufwand nichts ausrichten. Allerdings ist es nur bei wenigen Anwendungen wirklich ein Problem. |

| DC-Offset | X | - | unkritisch | Lässt sich mühelos per Filter entfernen. |

| Linearität, Klirrfaktor | X | X | mittel | Obgleich man auch diese Artefakte schlecht kompensieren kann, sind sie in der Praxis selten wirklich sehr stark. (Geeignete Einstellung des Mixers vorausgesetzt.) |

| Signal/Untergrund-Verhältnis | X | X | kritisch | Dagegen ist kein Kraut gewachsen. Manche Soundkarten schaffen gerade einmal 10-11 Bit (von angeblich 16). Onboard-Devices sind besonders betroffen. |

| Eingangsempfindlichkeit, Ausgangspegel | X | X | mittel | Manchmal kommen die auf den ersten Blick guten Eigenschaften einer Karte nicht so recht zum Tragen, da es nicht möglich ist, eine sinnvolle Aussteuerung zu erreichen. |

| Übersprechen | X | X | unkritisch | Selten sehr ausgeprägt, kompensierbar. |

| Recht/links Asymmetrie | X | X | unkritisch | Manchmal sind die Kanäle zeitversetzt, sonst unproblematisch. |

| Tonaussetzer, fehlende Samples, Datenfehler | X | X | kritisch | Soundkarten, die Da ein Problem haben sind schlicht Müll. Manchmal zeichnet aber auch der Chipsatz, das Lieblingsbetriebssystem oder ein amoklaufendes Programm dafür verantwortlich. |

| Resampling | X | X | mittel | Nur problematisch, wenn es schlecht implementiert ist. |

| Brummen | X | X | unkritisch | Das ist weitgehend Fehler 40 (sitzt 40cm vor dem Computer). ? Falsche Verkabelung. |

Der Frequenzgang ist einer der noch mit am öftesten in Soundkartentests

veröffentlichten Parameter. Möglicherweise deshalb stellt er in der

Praxis, wenn überhaupt, nur bei billigen Komponenten ein wirkliches

Problem dar.

Der Phasengang ist mit dem Frequenzgang im allgemeinen eng verkoppelt. Er

ist ist aber wenig relevant, da das Ohr die Phasenverhältnisse

unterschiedlicher Frequenzanteile praktisch nicht auflöst. Eine wichtige

Ausnahme ist, wenn sich linker und rechter Kanal

unterscheiden.

Hier wird gerne mal ein bisschen gespart. Entweder sind die Kondensatoren etwas klein geraten, oder sie leiden nach einigen Jahren an Altersschwäche. In jedem Fall äußert sich das normalerweise dadurch, dass der Frequenzgang nach unten mit typ. 6dB/Oktave abfällt - und zwar ab einer Frequenz, die noch im Hörbereich liegt. Bei guten Karten liegt der -3dB Punkt bei 10Hz oder weniger.

Rekonstruktionsfilter werden benötigt, um das typischerweise stufige

Ausgangssignal der D/A-Konverter auf das Frequenzband unterhalb der

Nyquist-Frequenz (halbe Samplingrate) einzuschränken und um den ebenfalls

auftretenden Höhenabfall zu kompensieren. Die Anforderungen an dieses

analoge Filter wären derart hoch, dass es vernünftig ist anzunehmen, das keine

Soundkarte in Serienproduktion ein qualitativ hochwertiges Exemplar

besitzt. Zudem müsste dieses Filter für jede Samplingrate anders ausgelegt

werden.

Glücklicherweise gibt es eine Alternative: die nennt sich Oversampling.

Diese von CD-Playern bekannte Technik umgeht das Problem in geschickter

Weise und führt die Filterung digital durch.

Zunächst einmal siehe Aliasing.

Eine Nebenwirkung der Anti-Aliasing-Filter ist, dass der Frequenzgang vor dem erreichen der Nyquist-Frequenz praktisch völlig einbricht. Dies ist unvermeidlich und als Indiz dafür zu betrachten, dass man sich bei der Konstruktion der Karte Gedanken um dieses wichtige Filter gemacht hat. Qualitative Unterschiede gibt es in der Steilflankigkeit.

Loopback Frequenzgang einer Terratec XLerate (Aureal Vortex Chip) bei 48 kHz, gemessen mit rosa Rauschen. Die Karte verwendet im Übrigen "nur" zweifach Oversampling.

Ob eine Karte in dieser Disziplin wirklich gut ist, kann man nur bedingt ohne professionelle Messtechnik feststellen.

Was man tun kann, ist ein Loopback-Test. Bei diesem Wird ein über Line-Out ausgegebenes Testsignal über Line-In sofort wieder digitalisiert. Aus den Unterschieden zum Referenzsignal kann man die Übertragugsfunktion von Line-In und Line-Out gemeinsam messen. Ob letztlich Line-In, Line-Out oder beide ein Problem haben, oder ob sich gar die Abweichungen kompensieren, wird man auf diese Weise nicht erfahren.

Weiß man, dass die Soundkarte ein Problem mit dem Frequenzgang hat, kann man die Auswirkungen davon (mit Ausnahme von Aliasing) durch digitale Filterung weitgehend kompensieren. Dazu muss man die zuvor gemessene Übertragungsfunktion invertiert auf die Audiodaten anwenden. Die Ein- und Ausgabe ist dabei jeweils für sich zu betrachten. Die Problematik ist, ohne "schweres Gerät" an die nötigen Informationen heranzukommen. Deshalb ist es im allgemeinen klüger, alles zu lassen wie es ist.

Dieser nur bei der Aufnahme auftretende Effekt entsteht im Moment der

Zeitquantisierung (Samplingrate) durch die Spiegelung hoher Frequenzen in

den Bereich unterhalb der Nyquist-Frequenz (halbe Samplingrate). Die

Frequenzen sind in der digitalen (zeitdiskreten) Darstellung nicht mehr

unterscheidbar.

Als Kandidaten kommen nicht nur Frequenzen direkt oberhalb der

Nyquist-Frequenz in Frage, sondern auch hohe Frequenzen, an denen es

üblicherweise im PC nicht mangelt. Voraussetzung ist nur, das sie es mit

hinreichend großer Amplitude bis in den ADC schaffen. Hinreichend groß ist

ein relativer Begriff. Zum Vergleich: 1 LSB (letztes Bit = eine

digitale ADC-Stufe) sind typischerweise ca. 45 µV an Line-In und noch

deutlich weniger an Mic-In. Wenn das Störsignal eine große spektrale

Breite hat, äußern sich die Aliasing-Artefakte durch einen Rauschteppich,

der sich im allgemeinen Signal/Untergrund-Verhältnis

negativ niederschlägt.

Ein steilflankiges, analoges Filter, dass alles ab knapp unterhalb der Nyquist-Frequenz platt macht, verhindert diesen Effekt. Daher der Name Anti-Aliasing-Filter. Da die Nyquist-Frequenz sich mit der Samplingrate ändert, muss das Filter für jede Samplingrate anders ausgelegt werden. Alternativ kann hier mit Oversampling (n-fach erhöhter Samplingfrequenz) gefolgt von digitaler Filterung gearbeitet werden. Manche ADC-Typen sind aufgrund interner Kapazitäten konstruktionsbedingt weniger anfällig gegen Aliasing als andere.

Das Aliasing nicht nur ein Problem der Soundkarten ist, beweisen einige CDs, bei denen beim Resampling auf 44,1 kHz üble Pfeifgeräusche den Weg auf den Master geschafft haben. So z.B. "The Best Of Bucks Fizz".

Ob eine Karte geeignete bzw. gute Aliasing-Filter hat, kann man nur mit professioneller Messtechnik herausfinden.

Auf die schnelle kann man bestenfalls beweisen, dass sie es nicht hat: Man nehme ein FM-Stereo Signal eines handelsüblichen Radios und nehme das mit 16 kHz auf. Wenn bei der Wiedergabe ein Pfeifen von 13 kHz auftritt, taugt das Anti-Aliasing-Filter (bei dieser Samplingrate) nichts.

Hinweise: hinter dem Experiment steckt die

Annahme, dass das verwendete Radio den 19 kHz Pilotton des

Stereo-Matrix Signals nicht sauber herausfiltert. Nach meinen Erfahrungen

ist das praktisch immer gewährleistet.

Des weiteren funktioniert das ganze nur bedingt mit AC97-Soundkarten, die

grundsätzlich mit 48 kHz sampeln und nachher herunterrechnen. In

diesem Fall misst man die Qualität des Resampling-Algorithmus

-

gleichwohl ebenso wichtig.

Wenn man Probleme mit Aliasing hat, ist man in der Praxis ziemlich aufgeschmissen, falls die Karte keine höheren als die gewünschte Samplingrate unterstützt. Wenn doch, kann man das Oversampling zu Fuß machen, indem man mit der doppelten Frequenz aufnimmt, und anschließend beim digitalen Downsampling digital filtert. Diese Methode ist außerordentlich wirkungsvoll. Allerdings ist es wenig zielführend, statt 44,1 kHz 48 kHz zu verwenden, da erstens das bisschen nichts bringt und zweitens das Resampling mit krummen Frequenzverhältnissen sehr aufwendig und auch tückisch ist.

Theoretisch wäre auch ein externes Analogfilter vor dem Line-In denkbar, aber der Aufwand übersteigt bei Weitem den für den Ersatz der Soundkarte durch ein besseres Modell.

Ein DC-Offset bedeutet, dass der digitalisierte Wert bei einer Eingangsspannung von 0 mehr oder minder deutlich von 0 verschieden ist. Mathematisch entspricht das einer Konstante, die zu allen Samples addiert wird. Am Analogausgang ist ein Offset eher unüblich.

Das Offset ist zunächst einmal nicht unmittelbar wahrnehmbar und daher unkritisch. Allerdings gibt es Nebeneffekte: so entsteht zum Beispiel beim Starten und Stoppen der Wiedergabe ein Knacken (ein Umkehrschluss wäre voreilig). Des weiteren kann das Offset beim nachträglichen Anheben der Lautstärke deutlich mit steigen und im Zusammenhang mit Kompression kann es zu tieffrequenten Störungen kommen, die an einem Subwoofer im Extremfall auch mal Schaden anrichten können.

Der mit dem Offset einhergehende Verlust an Aussteuerungsreserven ist normalerweise vernachlässigbar.

Ursache des Offsets sind Bauteiltoleranzen, die sich üblicherweise mit der Temperatur ändern. Je nach Bauart des ADCs (Analog-Digital-Konverter) fällt das Offset mehr oder minder groß aus. Manche Typen sind gänzlich dagegen immun, da sie keine Gleichspannung wandeln können, so z.B. die Delta-Sigma-Wandler - auch bekannt als 1 Bit Wandler.

Offsets gibt es auch bei anderen digitalen Quellen wie CDs. Es ist dann ursächlich schon beim Mastering aufgetreten und hat die gleichen Konsequenzen, wie auch bei der Soundkarte. Typische Kandidaten sind ältere AAD Aufnahmen. Mittlerweile kommt es eher selten in erwähnenswerten Größen vor.

Um das Offset des Line-In zu bestimmen schließt man selbigen kurz

(Eingang auf Masse) und macht eine (kurze) Test-Aufnahme. Das Ergebnis

kann man dann mit einem WAV-Editor oder auch einfach mit einem Hexeditor

begutachten. Das üblicherweise der Testaufnahme überlagerte Rauschen

kann man nachträglich mit einem gnadenlosen Tiefpass wegfiltern, der alles

oberhalb von 10 Hz platt macht.

Als Ergebnis erhält man Samples, die alle mehr oder minder den gleichen

Wert haben, nämlich den des Offsets. Nur der rechte und der linke Kanal

unterscheiden sich typischerweise deutlich. Liegen die Samples nahe 0

(<4) so hat die Karte praktisch kein Offset. Typisch sind Werte bis zu

einigen hundert.

Das Offset zu beseitigen ist mit einem einfachen, digitalen

Hochpass-Filter (Subsonic) möglich. Man trennt einfach die niedrigen

Frequenzen ab. Das Offset (0 Hz) ist dann auch mit verschwunden.

Das Filter kann im Nachhinein oder bereits während der Aufnahme angewendet

werden. Es eignen sich je nach Qualitätsanspruch Moving-Average-Filter

(spektral invertiert), IIR-Filter (alias rekursives Filter) oder auch

FIR-Filter (alias FFT-Filter). Für einfach Zwecke tut es das extrem

schnelle Moving-Average-Filter mit etwa einer Sekunde Zeitkonstante. Wer

es besser haben will, nimmt ein IIR Filter 2. Ordnung mit etwa 5 Hz

Übergangsfrequenz. Das ist etwas mehr Rechenaufwand, hat aber viel

weniger Latenz. Ein FIR-Filter ist für diesen Zweck Overkill, leistet aber

ggf. als Subsonic gute Dienste, ohne den Bass matschig zu machen.

Durch Nichtlinearitäten im Signalweg kann es zur Bildung von Oberwellen kommen (Klirren). Dies passiert vorwiegend im Bereich der Vollaussteuerung (0 dB). Hinzu kommt der bei der Analog-Digital-Wandlung (und vice versa) auftretendende Effekt der Differentiellen Nichtlinearität.

Es gibt in diesem Kontext zwei Arten von Nichtlinearität: Integrale Nichtlinearität und Differentielle Nichtlinearität.

Unter der Integralen Nichtlinearität (INL) versteht man den nichtlinearen Zusammenhang zwischen der Eingangsspannung und dem digitalen Ergebnis. Darunter fällt neben den Abweichungen des ADC selbst auch ein eventuelles Sättigungsverhalten (Übersteuerung) der analogen Verstärkerstufen. Im Ergebnis führt die INL zu harmonischen Verzerrungen.

Typischerweise stellt die Integrale Nichtlinearität kein nennenswertes Problem dar. Es gibt jedoch einige wenige Soundkarten, die so schlecht designt sind, dass sie bei digitaler Vollaussteuerung bereits analog übersteuern.

Die Differentielle Nichtlinearität (DNL) beschreibt Abweichungen im Abstand digital benachbarter Spannungswerte. Ursächlich sind Fertigungstoleranzen in den internen R2R-Netzwerken dafür verantwortlich. Typischerweise ist sie an Grenzen mit einem binären Übertag z.B. 0111111 -> 10000000 besonders groß.

Dieser zunächst unscheinbare Parameter kann, wenn er zu groß wird, die Zahl der effektiv nutzbaren Bits deutlich begrenzen. Die magische Grenze ist die Monotonität des ADCs oder DACs. Diese wird überschritten, wenn die DNL größer als ein LSB (= Spannungsauflösung) wird. Dann ist nämlich U(n+1) nicht mehr immer größer als U(n), oder anders formuliert, eine Erhöhung des digitalen Wertes kann eine Verringerung der Ausgangsspannung bedeuten. In diesem Moment ist das letzte Bit praktisch nicht mehr sinnvoll nutzbar. Bei schlechten Soundkarten kann die DNL mehrere Bits kosten. Die Angabe 16 Bit kann man in diesem Zusammenhang als geschönt bezeichnen.

Die Auswirkungen der DNL bei Aufnahme und Wiedergabe sind etwas unterschiedlich. Während bei der Aufnahme einige oder sogar viele der bei 16 Bit möglichen 65536 Kombinationen niemals erreicht werden, kommt es bei der Wiedergabe zu Verzerrungen.

Um die Integrale Nichtlinearität vernünftig zu messen, bedarf es professioneller Ausstattung in Form eines Signalgenerators.

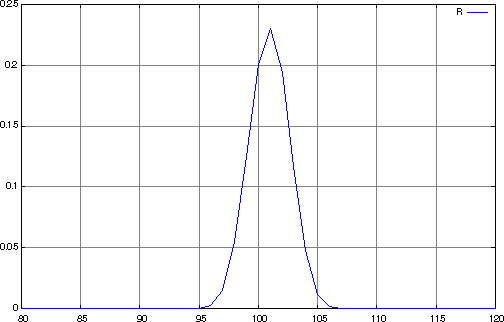

Die Differentielle Nichtlinearität des Eingangs kann man jedoch relativ leicht messen, indem man die statistische Häufigkeitsverteilung der einzelnen Samplewerte bei einem zufälligen Eingangssignal (rauschen) betrachtet. Normalerweise sollte ein Rauschen am Eingang eine gaußförmige Häufigkeitsverteilung liefern. Aufgrund der DNL ergeben sich aber deutliche lokale Abweichungen von einer Gaußkurve. Einige Werte kommen wesentlich häufiger vor, als ihre Nachbarn. Im Mittel der Umgebung stimmt es aber wieder in etwa. Im Extremfall fehlen einzelne oder sogar mehrere benachbarte Werte vollends. Das ist ein deutliches Zeichen für eine DNL größer 1 LSB.

Wenn man kein sonderlich solides quantitatives Ergebnis braucht, muss man sich bei der Wahl der Rauschquelle gar nicht so viel Mühe geben. Es reicht z.B. ein "verstelltes" Radiorauschen. Allerdings sollte man in diesem Fall nicht all zuviel auf die grobe Form der Gaußkurve geben, da andere Nichtlinearitäten, vor allem im Radio, ebenfalls das Bild verfälschen können.

Keine. In diesem Fall hilft nur Karte wegschmeißen.

Die Nutzbarkeit einer Soundkarte hängt ganz massiv vom Signal zu Untergrund Verhältnis (SNR) ab. Dieses misst man bei Soundkarten in dB FSR = relative Stärke der Störungen bezogen auf Vollaussteuerung. Manchmal wird dieser Parameter auch Dynamikumfang genannt, weil er das Verhältnis von leisesten sinnvoll verarbeitbaren Signal zu lautesten darstellt.

Unter den Parameter SNR fallen alle Störungen, die nicht mit dem Nutzsignal korreliert sind. Dazu zählen z.B. thermisches Rauschen oder auch systematische Störungen durch Einstreuung. Die Theoretische Grenze liegt beim Quantisierungsrauschen.

In der Praxis kann die nutzbare Dynamik auch durch die geringe Eingangsempfindlichkeit eingeschränkt werden. Das ist ein Trick, wie manche Hersteller ein gutes SNR erreichen. Dies gilt vor allem für die Mikrofoneingänge, die oft ohnehin jeder Beschreibung spotten.

Die in dem analogen Verarbeitungsweg verbauten Komponenten erzeugen ein mehr oder minder starkes Rauschen, das dem Nutzsignal überlagert wird. Anteile im Nutzsignal, die schwächer sind als dieses Rauschen, können im allgemeinen nicht mehr separiert werden und sind verloren.

Das thermische Rauschen ist temperaturabhängig. Mit steigender Temperatur wird es stärker.

Neben dem thermischen Rauschen gibt es auch andere unkorrelierte Einstreuungen, die sich dem Nutzsignal überlagern. Darunter fallen z.B. Störsignale aus dem Inneren des PCs. Aufgrund des Aliasings können auch hochfrequente Signale, z.B. von den Spannungsreglern, deutliche Störungen produzieren. Je nach Natur der Störquelle reichen die Auswirkungen von Rauschen bis zu Sirren, Kratzen oder Pfeifen.

Hörbare Störungen an Line-Out die mit diverses Systemaktivitäten korreliert sind, kommen häufig durch eine Masseschleife über das CD-Audiokabel herein. Dagegen hilft nur das Trennen der Verbindung. Gute Soundkarten bieten hier einen differentiellen CD-Eingang, der die Störungen weitgehend herausrechnet.

Das Quantisierungsrauschen ist ein notwendiges Artefakt der Digitalisierung. Sein SNR beträgt Anzahl der Bits * 6 dB. Das sind bei 16 Bit 96 dB. Das reicht für Audioanwendungen fast überall hin. Allerdings ist dieser Wert aufgrund anderer Störungen unerreichbar.

Samplewertverteilung des rechten Line-In-Kanals eines Onboard ALC650 Codecs auf Epox 8RDA+ ohne Eingangssignal. Die guten 80 dB SNR werden allerdings von der geringen Eingangsempfindlichkeit relativiert.

Das Signal/Untergrund Verhältnis (SNR) einer Soundkarte am Line-In kann man relativ leicht messen. Dazu schließt man an den Eingang 1 k-Widerstände gegen Masse. (Ein Kurzschließen des Eingangs liefert manchmal bessere Werte ohne Realitätsbezug.) Anschließend macht man eine Aufnahme. Die Aufnahmepegel müssen dabei auf Maximum bzw. einem realistisch hohem Wert stehen. Wenn man von dieser Aufnahme den RMS-Pegel nimmt, ist das bis auf das Minuszeichen das SNR.

Achtung: viele Programme schließen den DC-Wert in die RMS-Berechnung mit ein. Obgleich das mathematisch korrekt ist, kann es das Ergebnis ganz erheblich und ungerechtfertigt verschlechtern. Daher ist es in jedem Fall zu empfehlen, vor der RMS-Berechnung das Offset zu entfernen.

Gute Soundkarten liefern ein SNR von fast 90 dB. Das entspricht 15

von 16 Bit und liegt nahe des theoretischen Grenzwertes durch das

Quantisierungsrauschen.

Schlechte Karten kommen auf nur 60 dB und zum Teil sogar noch

weniger. Das entspricht gerade mal 10 Bit. Im übrigen ist das in etwa die

Dynamik von Vinyl-Platten (ohne Lagerfeuer). Allerdings ist das

Laufgeräusch der Nadel in der Rille aufgrund des anderen Frequenzspektrums

subjektiv weniger störend.

Für den Mikrofoneingang ist die Messung gesondert durchzuführen. Dort wird man deutlich schlechtere Werte erhalten.

Das SNR der Ausgänge ist nicht mit so einfachen Mitteln messbar, dazu bedarf es wiedermal Profiausrüstung.

In einigen Fällen hilft es, die Soundkarte in einen anderen Slot zu

stecken - möglichst weit Weg von anderem Getümmel, vor allem CPU, IDE- und

SCSI-Kabel.

In den meisten Fällen bringt aber nur eine andere Sound-Hardware spürbare

Verbesserungen. Mir ist es in Einzelfällen gelungen, durch

Entstörmaßnahmen auf der Karte (zusätzliche Filterkondensatoren etc.) ein

paar dB herauszuschinden.

Störungen am Ausgang, die mit Systemaktivitäten korreliert sind, kommen meist über das CD-Audiokabel. Man beseitigt sie, indem man den CD-Eingang stumm schaltet bzw. besser noch das Kabel absteckt. Für die CD-Wiedergabe ist dann die digitale Übertragung zu wählen. (Dann stört nur noch das CD-ROM, das mit wahnsinniger Geschwindigkeit an den Audiodaten vorbeidröhnt.)

Obgleich dies eigentlich kein unmittelbarer Qualitätsfaktor ist, kann er entscheidenden Einfluss auf die nutzbare Dynamik haben. Denn wenn es trotz "alle Knöppe auf zehn" nicht gelingt, eine sinnvoll hohe Aussteuerung zu erreichen, gehen die fehlenden dBs direkt vom realen SNR ab. Das betrifft vor allem die Mikrofoneingänge. Aber auch an den normalen Eingängen kann sich das deutlich negativ auswirken, wenn man ein etwas schwaches Eingangssignal hat, wie es z.B. beim digitalisieren von LPs häufig vorkommt.

Beim Ausgangspegel habe ich noch keine allzu großen Abweichungen gesehen. Allerdings haben neuere Soundkarten und vor allem sämtliche Onboard-Lösungen keine Leistungstreiber mehr, weshalb der Anschluss passiver Lautsprecher und niederohmiger Kopfhörer nicht möglich ist, bzw. ein leises oder verzerrtes Signal liefert.

Manche Hersteller beschönigen das SNR indem sie die Verstärkung herabsetzen. Dabei werden natürlich auch die Störungen weniger verstärkt.

Man könnte die Eingangsempfindlichkeit natürlich messtechnisch erfassen, aber nützlicher ist es, unter konkreten realen Bedingungen einfach eine Aufnahme zu starten und sich die erreichbare Aussteuerung anzusehen. Wenn man dann bei maximal -15 dB Peak liegt, hat man in der Regel ein Problem.

Falls möglich sollte man das Quellsignal vorverstärken. Ist das nicht möglich, hat man im wahrsten Sinne des Wortes schlechte Karten.

Ausgangsseitig sollte man im Fall des Falles Aktivboxen bzw. hochwertige Kopfhörer mit > 100 Ohm verwenden. Alternativ bietet sich der Anschluss eines Handelsüblichen HiFi-Verstärkers an.

Das Übersprechen bezeichnet den Anteil des Signals, der vom jeweils anderen Kanal kommt. Also der linke Kanal enthält Signalanteile des rechten Kanals und vice versa. Unser Ohr ist für übersprechen nahezu taub, deshalb ist dieser Parameter ziemlich unkritisch.

Die zum Steresignale werden häufig parallel geführt oder sogar gemeinsam verarbeitet (gemultiplexter ADC). dabei kommt es zu einer mehr oder minder starken Vermischung der Signale. Das Übersprechen ist normalerweise frequenzabhängig und nimmt üblicherweise mit der Frequenz zu.

Übersprechen kann praktisch an allen Stelen des Signalwegs auftreten, also nicht nur in der Soundkarte.

Übersprechen ermittelt man, indem man an einen Kanal ein Signal anlegt, während man den anderen auf null lässt. Danach setzt man die beiden aufgenommenen Signale ins Verhältnis. Ab etwa 30 dB Unterschied muss man sich keine Sorgen mehr machen.

Ursächlich kann man eigentlich nur die Kabelführung auf ungeeigneter weise gemeinsam abgeschirmte Stereokabel prüfen. Diese erkennt man meist am Querschnitt: rund und nicht dicker als etwa 3 mm.

Wenn man das Übersprechen in Betrag und Phase kennt (gemessen hat), kann man die Auswirkungen durch eine Stereo-Matrix-Filterung weitgehend kompensieren.

In Holzhammermarnier findet man so etwas in Form eines "Wide-Stereo" Schalters zuweilen an Gettoblastern. Das führt selten zum gewünschten Ergebnis.

Einige Parameter, die für sich genommen unkritisch sind, können sehr problematisch werden, wenn sie sich für den rechten und den linken Kanal signifikant unterscheiden. Darunter fallen Phasendifferenz und unterschiedliche Eingang- bzw. Ausgangspegel. Da über diese differentiellen Parameter die akustische Ortung der Ohren funktioniert, wird eben diese dadurch beeinträchtigt. Im Bassbereich kann es zudem zu einem beschleunigtem Lautstärkeabfall mit niedriger werdender Frequenz führen.

Aufgrund von konstruktionstechnischen Details und Toleranzen kann es vorkommen, dass sich Amplitude und Phase der Übertragungsfunktion bei einer Frequenz zwischen linkem und rechten Kanal deutlich unterscheidet. Dabei kommen drei typische Ursachen in betracht:

Vor allem am unteren Ende des Frequenzspektrums können Toleranzen in den frequenzbestimmenden Kondensatoren zu unterschiedlichen Grenzfrequenzen führen. Vor allem billige Elkos haben zum Teil bis +50%/-20% Toleranz. Neben der unterschiedlichen Grenzfrequenz hat das aber auch Auswirkungen auf die Phasenlage. Dadurch kommt es dazu, dass sich die Bässe des linken und rechten Lautsprechers nicht mehr vollständig addieren. Das beschleunigt den Lautstärkeabfall bei niedrigen Frequenzen zusätzlich.

Diese kommen durch Bauteiltoleranzen der Widerstände. Sie sind im allgemeinen unkritisch, da kleiner 5%.

Einige Soundkarten verwenden einen gemeinsamen ADC bzw. DAC für den linken und den rechten Kanal. Dieser arbeitet dann bei der doppelten Frequenz. (Bei mehrkanaligen Karten kann der Faktor auch höher sein.) Wenn bei dieser Vorgehensweise keine zusätzlichen, analogen Sample-and-hold-Stufen zum Einsatz kommen, ist das Signal des einen Kanals gegenüber dem anderen Kanal zeitlich versetzt - und zwar um genau ein halbes Sample. Das hört sich wenig an, ist aber am oberen Ende des Frequenzspektrums immerhin 90°. Ich habe auch schon Karten gesehen, die es irgendwie schaffen auf 180° zu kommen - wie ist mir ein Rätsel.

Die Toleranzen der Kanäle können durch Loopback-Messungen bei geschicktem

Kombinieren der Ein- und Ausgangskanäle relativ genau vermessen werden.

Zunächst muss man die Eingänge kalibrieren. Dazu verbindet man den Ausgang

des linken Kanals mit beiden Eingängen, links und rechts. Gibt man jetzt

ein möglichst breitbandiges Referenzsignal auf den Ausgang, am besten

Rauschen, und nimmt dieses gleich wieder auf, so kann man aus der Aufnahme

die frequenzabhängigen Differenzen in Phase und Amplitude der beiden

Eingänge berechnen. Man muss dazu beide Kanäle per FFT transformieren und

den komplexen Quotienten der beiden FFTs bilden. Sinnvollerweise trägt man

das in einem Bodediagramm (Amplitude und Phase getrennt) auf.

Falls alles in Ordnung ist, liegt das Ergebnis über das komplette

Frequenzspektrum nahe bei 1 für die Amplitude und nahe 0 für die Phase.

Ist die Amplitude in weiten Bereichen gleich aber eben nicht genau 1.0, so

hat man eine Abweichung in der Verstärkung. Werte zwischen 0,95 und 1,05

sind unkritisch.

Am den Enden des Frequenzspektrums gehen die Werte meist etwas

auseinander. Phasenabweichungen von bis zu 20° bei 20 Hz bzw.

20 kHz sind noch tolerabel. Wenn es mehr wird, hat man ein Problem.

Von diesen Extrempunkten sollten die Phasendifferenzen zur Mitte hin sehr

schnell auf maximal +/- 3° fallen. Ein serieller A/D-Wandler äußert

sich in einem linearen Anstieg der Phasendifferenz von 0 am unteren Ende

des Frequenzspektrums auf 90° am oberen Ende.

Um die Differenzen in der Ausgänge zu messen, geht man ähnlich vor. man verbindet jetzt den linken Ausgang mit dem linken Eingang und den rechten Ausgang mit dem rechten Eingang. Als Testsignal gibt es wieder das Rauschen, das jetzt notwendigerweise Mono sein muss. Allerdings sollte man es in Stereo abspielen - also eine Stereodatei bestehend aus zwei absolut identischen Spuren -, da einige Soundkarten bei Monodateien ein anderes Wiedergabeverfahren benutzen. Man bildet wieder den komplexen Quotienten der beiden FFTs, der jetzt zusätzlich um die Differenz aus der vorhergehenden Eingansmessung korrigiert werden muss (auch eine komplexe Division). Das Ergebnis ist in gleicher weise zu interpretieren, wie die Eingangswerte.

Im Prinzip kann man solche Unterschiede durch digitale Filterung nach der Aufnahme bzw. vor der Wiedergabe kompensieren. Die Vorgehensweise ist dabei die gleiche, wie bei der Kompensation allgemeiner Frequenzgangunterschiede. Die Filterung ist allerdings ein relativ aufwendiges FIR-Filter, das entsprechend CPU-Last und vor allem Latenz kostet.

Nicht in die Kategorie der analogen Probleme aber gleichermaßen wichtig ist die Zuverlässigkeit der digitalen Übertragung selbst. Allerdings sind Ursachen derlei Probleme nicht so einfach zu ergründen.

Aus verschiedenen software- oder hardwaretechnischen Gründen kann es zu Störungen bei der digitalen Übertragung der Daten von der Soundkarte zur verarbeitenden Applikation und vice versa kommen. Im folgenden sind einige mögliche Ursachen genannt. Die meisten davon fallen in die Kategorie Probleme mit Prozess- und Hardwareprioritäten.

Da weder Windows (in allen Varianten) noch Linux noch OS/2 noch etliche andere Betriebssysteme echtzeitfähig sind (solche mit garantierten Worst-Case Reaktionszeiten) und auch in absehbarer Zeit nicht werden, kann letztlich nicht zu 100% garantiert werden, dass die verarbeitenden Applikationen ihren Aufgaben immer hinreichend schnell nachkommen. Letztlich löst man das Problem, indem man mehrere Verarbeitungsstufen mit jeweils größeren Puffern getrennt auf unterschiedlichen Prioritäten arbeiten lässt.

Das beginnt mit einem Hardware-Puffer auf der Karte, der über den PCI-Bus mit dem RAM kommuniziert. Dieses wird vom Treiber im Interruptkontext (höchste Priorität) verwaltet. Dieser steht mit typischerweise auf zeitkritischer Priorität laufenden Applikationsteilen in Verbindung, welche wiederum mit anderen Applikationsteilen auf niedrigeren Prioritätsebenen kommunizieren. Zu guter Letzt werden die Daten typischerweise über Festplatte oder Netzwerk be- oder entsorgt. In diesem Schritt haben sie keine besondere Priorisierung mehr.

Auf jeder dieser Ebenen kann es zu Engpässen kommen. Diese führen dann

unweigerlich zu Aussetzern (Wiedergabe) oder Datenverlust (Aufnahme), da

die betreffenden Puffer voll- bzw. leerlaufen.

Der PCI-Bus kann durch andere Devices (z.B. Videokarte oder IDE-Transfers)

blockiert sein. Das trifft ältere VIA-Chipsätze besonders hart, da diese

das PCI-Arbitrierungsprotokoll zur Verteilung der PCI-Bandbreite nicht

implementiert haben (Der berühmte VIA-Bug steht damit im Zusammenhang).

Die Interruptverarbeitung kann blockiert sein, weil eine andere, langsame

Karte auf dem gleichen Interrupt die Leitung zu lange blockiert oder sie

oder ihr Treiber das IRQ-Sharing nach 12 Jahren PCI-Bus immer noch nicht

kann. Denkbar ist auch, dass die Verarbeitung eines höher priorisierten

Interrupts zu lange dauert. Die Applikation kann trotz hoher Priorität von

anderen ebenfalls hoch priorisierten Anwendungen ausgebremst werden. Die

Festplatte kann aufgrund anderer Anfragen so langsam reagieren, dass sie

der Datenrate für die Echtzeitanwendung nicht mehr stand hält.

Desktop-Platten sind wegen ihrer schlechten Zugriffszeit anfälliger.

Notebookplatten um so mehr.

Eine ursächliche Analyse ist ob der vielfältigen Ursachen kaum allgemein zu beschreiben. Allerdings kann man die Zuverlässigkeit testen, indem man ein bekanntes, periodisches Signal über einen längeren Zeitraum auf Line-Out ausgibt und per Loopback wieder digitalisiert. Das wieder aufgenommene Signal sollte man dann von Zeit zu Zeit analysieren und vor allem vergleichen, ob sich die Phasenlage geändert hat. Diese muss selbst unter widrigsten Umständen auf lange Sicht stabil bleiben. Dazu müssen die Stichproben natürlich im Abstand eines Vielfachen der Signalperiodizität gemacht werden.

Die Gegenmaßnahmen sind mindestens ebenso vielfältig, wie die Ursachen. Das reicht vom Beschaffen ordentlicher Hardware über fehlerarme Treiber, ordentliche Audio-Software bis hin zum Deaktivieren allzu selbstherrlicher und von blindem Aktivismus getriebener Software. (Die MS Office Indexerstellung fällt mir da als historisches Highlight ein.) Bei Aufnahmen kann man ferner unter Inkaufnahme dabei meist irrelevanter Latenz sehr großzügige RAM-Buffer im zweistelligen MB-Bereich verwenden. Darurch ist das Thema Platte faktisch entkoppelt, weil diese seltenst über 10 Minuten unter Volllast steht.

Viele neuere Soundkarten mit AC97-Kompatibilität konvertieren alle Sounddaten (zunächst) nach 48 kHz. Dieses viel verschriene Feature ist theoretisch gar nicht so kritisch. In der Praxis ist aber die Umsetzung zuweilen mangelhaft. Die Notwendigkeit einer bitgenauen Wiedergabe existiert aus audiotechnischer Sicht nicht.

Neuere Soundkarten arbeiten intern fest mit 48 kHz. Das hat verschiedene Vorteile: so müssen die Anti-Aliasing-Filter und die Rekonstruktionsfilter nunmehr nur noch für eine Frequenz ausgelegt werden. Das erspart Kosten, bzw. erlaubt bei gleichen Kosten bessere Ergebnisse. Des weiteren ist es dadurch möglich, auf einer Soundkarte verschiedene Soundquellen mit verschiedenen Samplingraten gleichzeitig wiederzugeben, z.B. Systemsounds und eine MP3-Wiedergabe. Das war mit älteren Karten nicht möglich. Zudem ist es nun möglich den Mischer, der die verschiedenen physikalischen Soundquellen (MIDI, Wave, Line-In etc.) zusammenführt digital auszuprägen. Das ist zum einen ein Kostenvorteil, zum anderen ermöglicht es erst die digitale Ausgabe (SP-DIF) eines zusammengesetzten Signals.

Der Nachteil ist die immer erforderliche Umrechnung auf 48 kHz bzw. umgekehrt. Die Konvertierung der Samplingrate ist zunächst einmal nach dem Nyquist-Theorem verlustfrei. Durch die gleichzeitige Wertquantisierung (16 Bit) ist allerdings eine Requantisierung erforderlich, die dem Signal ein Quantisierungsrauschen hinzufügt. Dieses liegt in der Größenordnung -96 dB (bei 16 Bit) und ist gemessen an den anderen Störungsquellen vernachlässigbar.

In der Realität ist die Konvertierung der Samplingrate aber fast immer ein Kompromiss zwischen Rechenaufwand, Latenz und Qualität. Lediglich einfache, ganzzahlige Verhältnisse, wie 1:2 sind ohne größeren Aufwand möglich. Die häufig benötigte Konvertierung 44100 <-> 48000 ist allerdings keineswegs trivial und entsprechend auch das Problemkind.

Technisch gesehen, gibt es zwei Varianten. In der ersten, billigen

Variante kann die Soundhardware ausschließlich mit 48 kHz umgehen.

Das Resampling wird dann vom Treiber gemacht. Das kostet je nach Qualität

ganz ordentlich CPU-Leistung. Die Nutzbarkeit der digitalen Aus- und vor

allem Eingänge ist in dabei im allgemeinen stark eingeschränkt.

In der zweiten, etwas besseren Variante erledigt das Resampling der DSP

der Soundhardware. Qualitativ gibt es bei beiden Varianten das komplette

Spektrum mit einem Schwerpunkt bei minder qualitativen Lösungen.

Um die Qualität der Resampling-Algorithmen zu bewerten, muss man zunächst einmal Zugang zu den digitalen Daten vor und nach dem Resampling haben. Bei Karten mit SP-DIF Ein- und Ausgang kann man sich mit einem digitalen Loopback behelfen. Man gibt dazu einfach Rauschen (=Zufallszahlen) in 44,1 kHz (oder einer anderen zu Testenden Samplingrate) auf den Ausgang. Üblicherweise reicht es von dem wieder aufgenommenen Signal ein FFT zu machen, um eventuelle Untaten zu erkennen. Idealerweise sollte das Rauschen dann knapp unter 22,05 kHz schlagartig abbrechen und insbesondere keine erheblichen Verformungen im Frequenzgang sichtbar sein.

Die umgekehrte Richtung macht man analog dazu. Ein 48 kHz Rauschen wird über SP-DIF ausgegeben und eine Aufnahme mit 44,1 kHz gestartet. In diesem Fall sollte das Rauschspektrum bei knapp 22 kHz beschnitten werden und insbesondere keine Überhöhung durch Aliasing im oberen Frequenzbereich aufweisen.

Den oben genannten Verfahren liegt die Annahme zugrunde, dass jegliches Resampling unabhängig vom Ein- oder Ausgang mit dem gleichen Algorithmus durchgeführt wird.

Falls die Sampleratenkonvertierung der Karte untauglich ist, kann man sich behelfen, indem man grundsätzlich nur mit 48 kHz aufnimmt und wiedergibt und die Konvertierung vorher bzw. nachher selbst mit geeigneter Software durchführt. Das ist leider relativ viel Aufwand und im Falle von SP-DIF Signalen mit ungleich 48 kHz nicht sinnvoll praktikabel.

Erstens: Soundkarten Brummen nicht.

Zweitens: Allerdings gilt das nicht für die Auswirkungen einer

ungeeigneten Verkabelung.

Die Eingänge von Consumer-Soundkarten sind asymmetrisch. Das bedeutet das Eingangssignal wird bezogen auf die lokale Masse interpretiert. Damit das trotzdem funktioniert, wird mit jeder Audioverbindung auch eine Masseverbindung zwischen den beteiligten Geräten hergestellt. Das geht genau solange gut, wie die betreffenden Geräte vorher potentialfrei waren, d.h. ohne andere Verbindung - wenn nicht, hat man eine Masseschleife und schon brummt es. Eine Masseschleife ist wie ein riesiger Transformator. Sobald sie von einem Wechselstrom-Magnetfeld durchflutet wird (und das geht schneller als man denkt), fließt ein Ringstrom. Dieser erzeugt einen Spannungsabfall am Widerstand der Masseverbindungen, und damit stimmt die Masse des Signal einspeisenden Geräts nicht mehr mit der des weiterverarbeitenden Geräts überein. Da selbige das Signal jeweils auf ihre lokale Masse beziehen, sehen sie zwar noch dasselbe Signal, interpretieren es aber anders.

Ein Brummen mit 50 Hz oder einem Vielfachen davon ist, wenn es nicht schon in der Soundquelle vorhanden war, fast immer eine Masseschleife. Ein deutliches Indiz ist, wenn sich das Brummen durch Trennen anderer Masseverbindungen wie z.B. Antennenkabel ändert bzw. bessert.

Es gibt nur einen Weg: man unterbricht die Masseschleife. Je nach Art der

Verbindung gibt es geeignete Massetrenner. Antennensignale trennt man mit

einem DC-tauglichen Mantelstromfilter, Audiosignale mit einem Übertrager

oder digitaler optischer Übertragung (Toslink), Stromversorgungsleitungen

mit einem Trenntrafo etc. (in steigender Preisklasse genannt). Bei

Videosignalen hat man faktisch kaum eine Chance.

Im übrigen reduzieren all diese Maßnahmen auch maßgeblich die

Überspannungsanfälligkeit der Geräte bei steilen Transienten wie bei

Gewitter.

Jenseits der billigen 16/48-Karten gibt es noch die 24/96-Klasse (24 Bit, 96 kHz). Für den Hausgebrauch ist das eigentlich überdimensioniert. Interessant wird das im professionellen Bereich (die 24 Bit) und für messtechnische Anwendungen (die 96 kHz).

Am entscheidendsten ist aber, dass diese Karten (bisher) lange nicht die Qualitätsprobleme haben wie die 16/48-Liga. Zwar kommen auch da nicht wirklich 24 signifikante Bits raus, doch liegt man mit üblicherweise deutlich über 100 dB SNR schon jenseits dessen, was übliche Stereoanlagen (und vor allem Surround-Anlagen) zu leisten vermögen. Ich fürchte jedoch, dass spätestens mit der Einführung des AC97-Nachfolgers aufgrund der nunmehr durch den Endanwender noch schwerer wahrnehmbaren Qualitätsunterschiede die Schere zwischen der Spezifikation und der Realität noch weiter klaffen könnte.

Anmerkungen, Ergänzungen, Einwände (nur nicht zu viele :-): ![]()